Optimal Brain Damage : 局所二次近似と極値判定(凸関数, 勾配, ヘッセ行列)

このポストでは,ニューラルネットワークモデルにおける「パラメータを訓練(学習)させるためのアルゴリズム」に注目したいと思います.ニューラルネットワークモデルについては,

「特徴量(=パラメータ)を人間が与えなくとも,機械(=コンピュータ)が勝手にその "重要度" を評価し,学習する」

という内容で,その新奇性を紹介されることが多いですが.この主張の要点は,

- 各重み (params) の性能への"寄与度"を機械 (model) が自動的に評価すること

- 各重み (params) の性能への"寄与度"を機械 (model) が評価した後に,その情報を機械 (model) に反映させること

の2つに集約できます.しかし,前者に関しては,適応信号処理や情報検索,機械学習などで既に多くの一般的な研究成果が与えられているため,ニューラルネットワーク特有の性質とは言えません.その意味で,個人的には,後者:「各重み (params) の性能への"寄与度"を機械 (model) が評価した後に,その情報を機械(model) に自動的に反映させること」こそがニューラルネットワークモデルのクリティカルな性質であると言って良いでしょう.そしてこれは,具体的に「誤差逆伝播法」というアイデアと,これを解くための「最急降下法」という最適化アルゴリズムに基づきます.

以上を踏まえ,このポストでは,ニューラルネットワークモデルの核である「誤差逆伝播法」「最急降下法」に注目した上で,その原理となる「局所二次近似」や「凸最適化」についてまとめてみたいと思います.

1. 背景

Optimal Brain Damage (: OBD)とは,ニューラルネットワークを用いた目的変数の予測問題において、パラメータ数を縮減するための方法であり,局所二次近似 (Approximation of Second-order Derivatives) とは,OBDを実装する際に必要となる計算アルゴリズムのことです。具体的には,目的関数(=誤差関数, 損失関数)を2次の項までのテイラー展開によって近似することで,あるパラメータの組み合わせに対する「勾配」を求めます.

なお.OBDは、Yann Le Can らによって書かれた初期のニューラルネットワーク研究における有名な論文:Optimal Brain Damage [Yan, et al. 1990]によって提案されました.また,OBDに関連する概念・用語としては,以下のようなものが挙げられます.

- OBD: Optimal Brain Damage

- OBS: Optimal Brain Surgeon

- OCD: Optimal Cell Damage

ここからは、局所二次近似について考えてみましょう.

2. 準備:凸関数とテイラー展開

まず,凸関数(Convex function),勾配(Gradient),ヘッセ行列(Hessian)の定義を与えます.

2. 1. 凸関数

n個のスカラー変量 からなる多変数関数:

を考える.

定義域上の任意の2点 (n次元ベクトル)において,次の不等式を満たすとき,

を「凸関数」(: Convex function)という.

なお,等号成立がの場合に限るとき,

を「狭義の凸関数」という.

2. 2. 勾配 - Gradient

n個のスカラー変量 からなる多変数関数:

を考える.

が,任意の変数

について1階偏導関数が定義されているとき,

に対する1階微分の情報を包括的に含む以下のn次元ベクトル

が定められる.これを「

の勾配(gradient,

」という.

2. 3. ヘッセ行列 - Hessian Matrix

n個のスカラー変量 からなる多変数関数:

を考える.

が,任意の変数

について2階偏導関数が定義されているとき,

に対する2階微分の情報を包括的に含む以下のn×n正方行列:

が定められる.これをヘッセ行列という.

ただし,ヘッセ行列の各要素は次のように定義される.

2. 4. テイラー展開による2次の近似

n個のスカラー変量 からなる多変数関数:

を考える.

テイラー展開より, を任意の点

によって近似すると,次式を得る.

ここで、を、2次までのテイラー展開によって近似すると、

となり、既知の値 によって、

を推定することができる。

3. 局所二次近似

さて,ここまでの議論で共通して登場してきた

「n個のスカラー変量 からなる多変数関数:

」

は,予測問題の文脈では

「n次元のベクトル に関する誤差関数(=目的関数):

」

とみなすことができます.

誤差関数 に対するパラメータベクトル

に,既知の値

を与えて,2次のテイラー展開によって近似してみましょう.

- 誤差関数を最小にするようなパラメータベクトル

を求めたい.

- 誤差関数はパラメータベクトル

に対して凸関数となる.

誤差関数の

coming soon ..

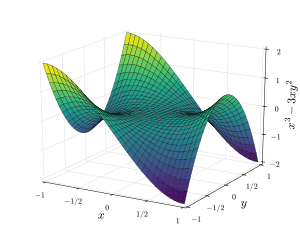

4. 極値判定

x において正定値対称行列であるとき、f は x において極小である。

x において負定値対称行列であるとき、f は x において極大である。

x において正負両方の固有値を持つとき、x は f の鞍点である(これは x が退化する場合にも正しい)。

coming soon ..